主要是一些配置,同时算是备忘手册

本地部署DeepSeek

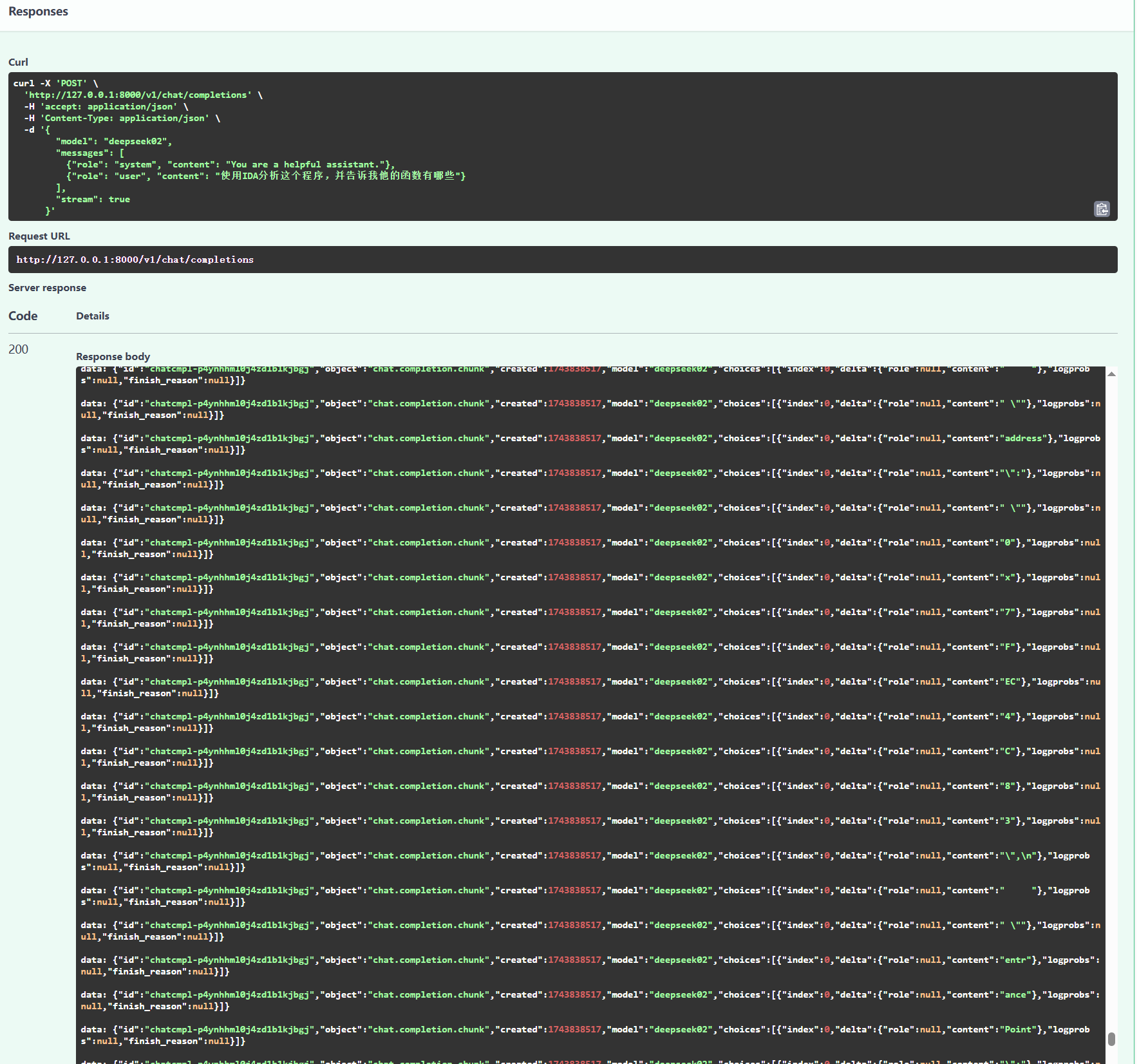

首先是部署DeepSeek R3

我是使用的是LM Studio,下载链接:https://lmstudio.ai/

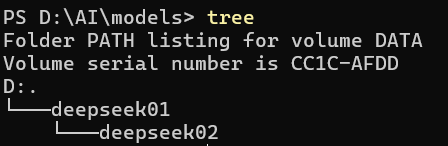

下载完成后需要按照如下逻辑结构创建文件夹:

然后下载DeepSeek的模型,国内可以通过魔塔社区等下载,会快很多。

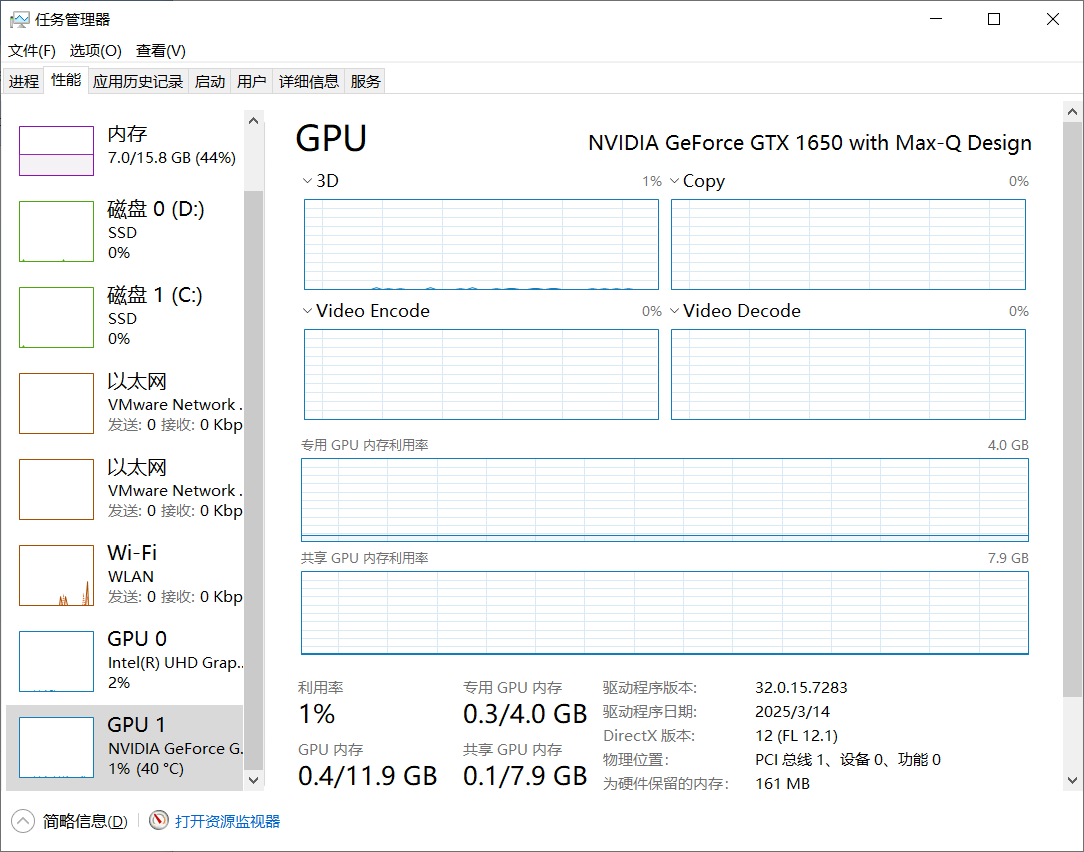

我的显卡是GTX1650 MaxQ,显存只有4G。使用:DeepSeek-R1-Distill-Qwen-7B-GGUF

AI相关最重要的就是显卡的显存,关于显卡参数可以在 任务管理器 -> 性能 中看到,如果只有一个intel的集显,那么得下载对应的显卡驱动。

deepseek 1.5b:几乎没有显卡要求deepseek 7b: 至少4G显存deepseek 8b: 至少6G显存deepseek 14b: 12G显存deepseek 32b:至少24G显存

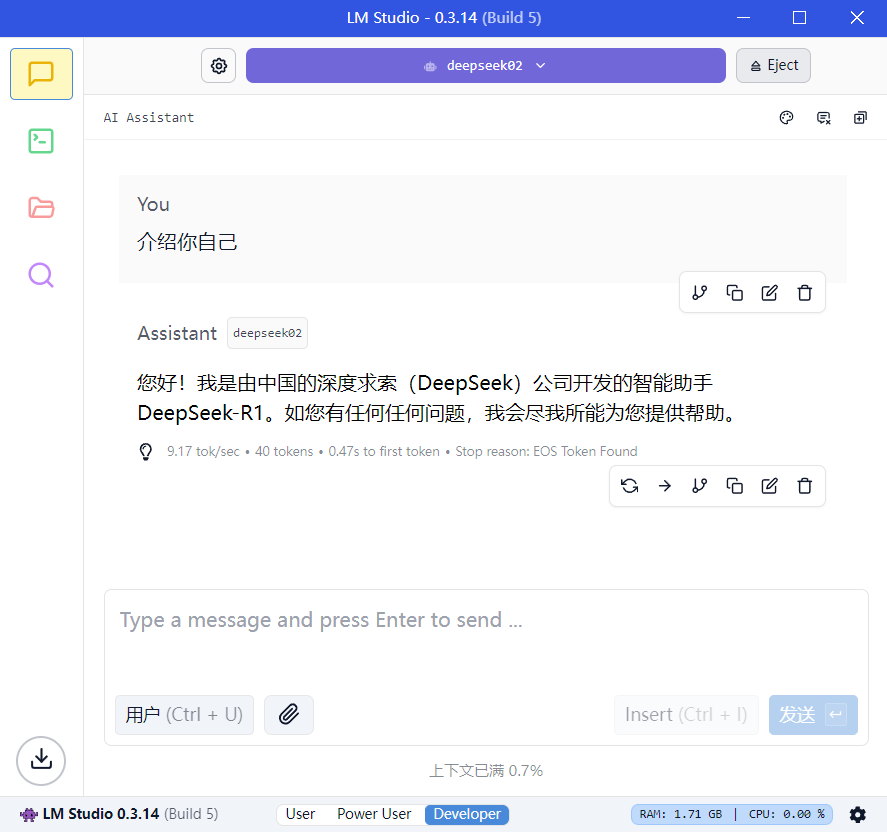

如果配置正确就可以在LM Studio中看到了

一般配置如下

建议开启 闪电注意力(Fast attention),同时如果需要使用MCP建议将上下文长度改为至少 8192

等待模型加载后即可使用。 使用完成后记得弹出!

MCP使用

这里讲最简单的使用:下载一个 5ire

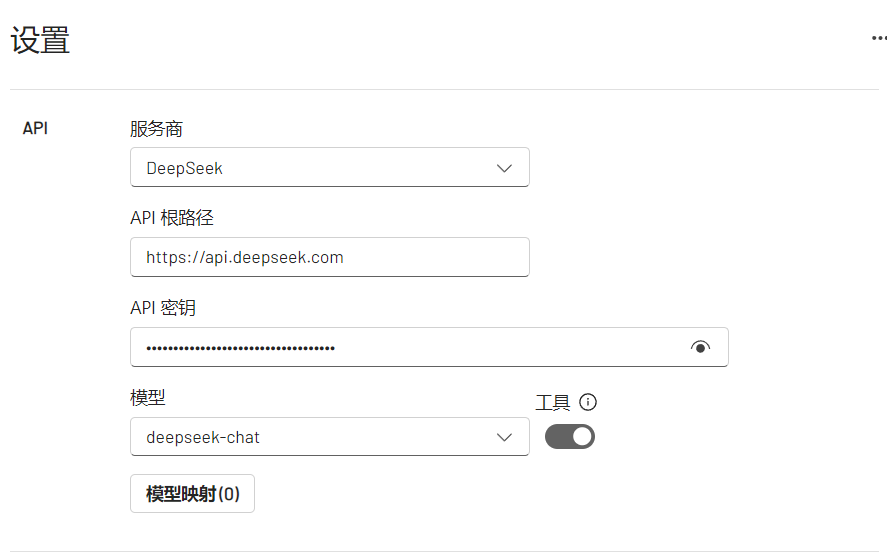

在这里设置相关参数,如:使用Deepseek的官方API

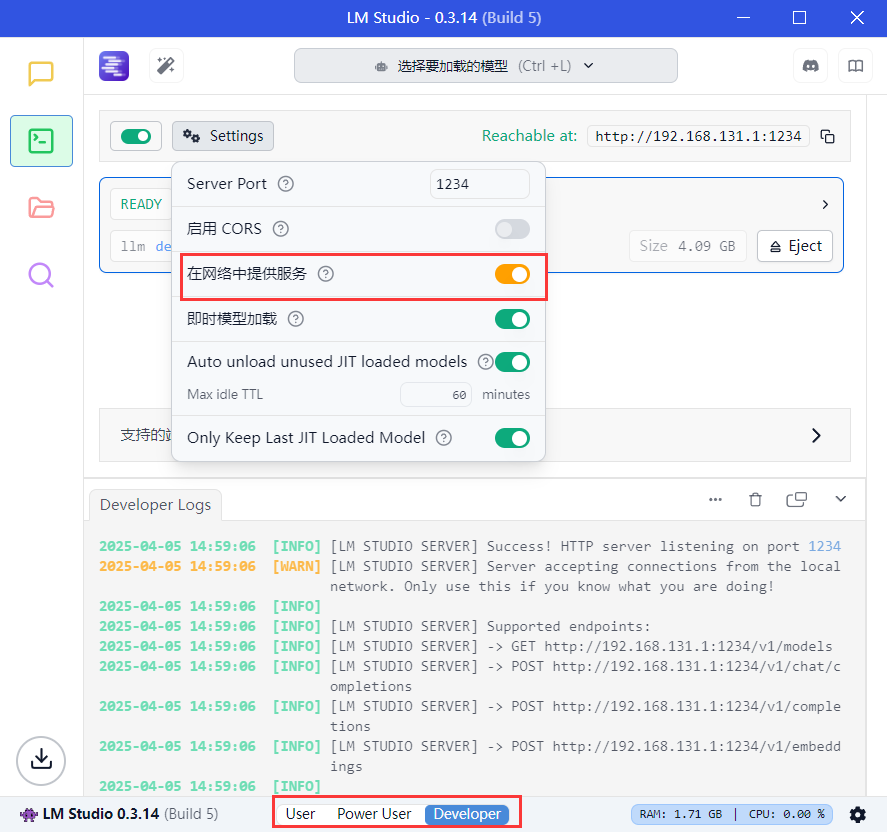

如果使用本地的AI,需要设置下LM Studio

然后在5ire中设置如下:

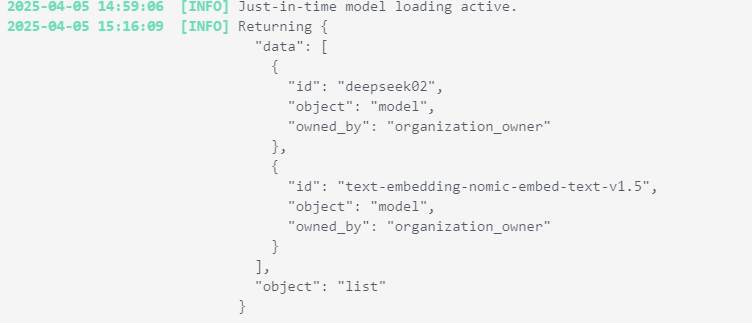

这里的模型应该在连接成功后即可使用选择,并且在LM Studio中能看到API请求如下

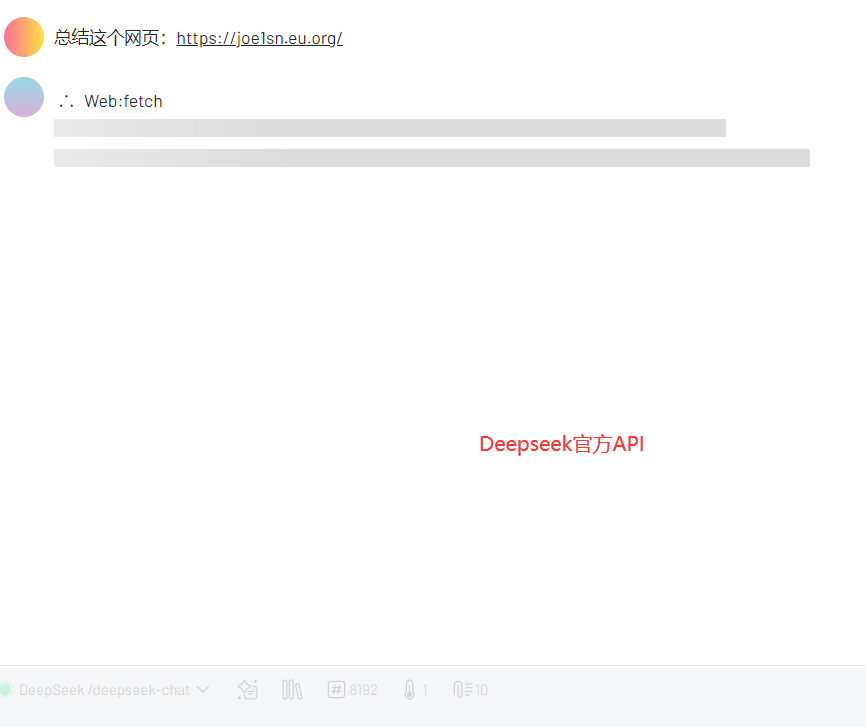

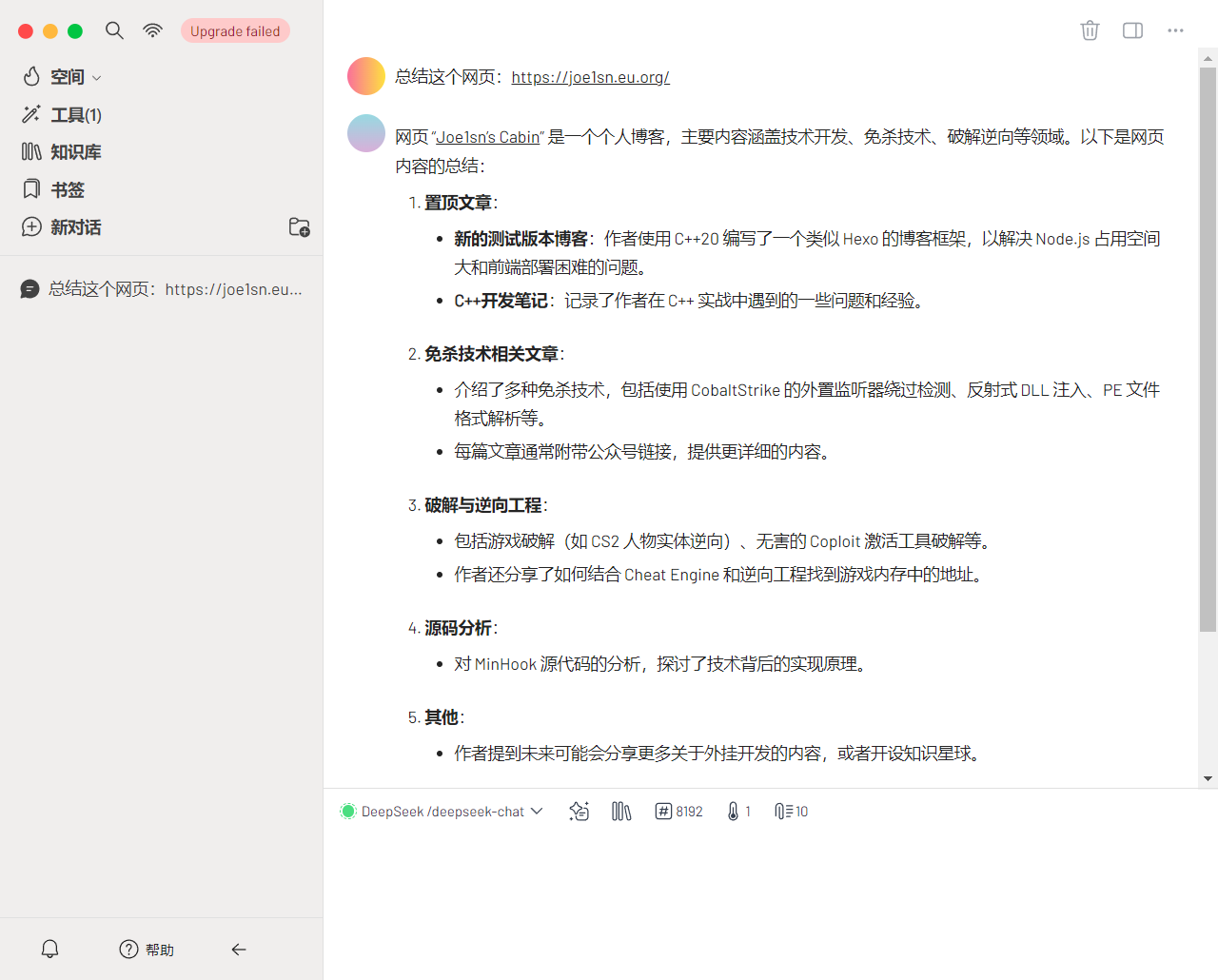

在工具->工具市场中可以看到许多MCP Server,这里已Web举例,这个MCP的功能是访问网页

安装完成后需要在工具中启用

之后点击 新对话 就可以使用了,如:

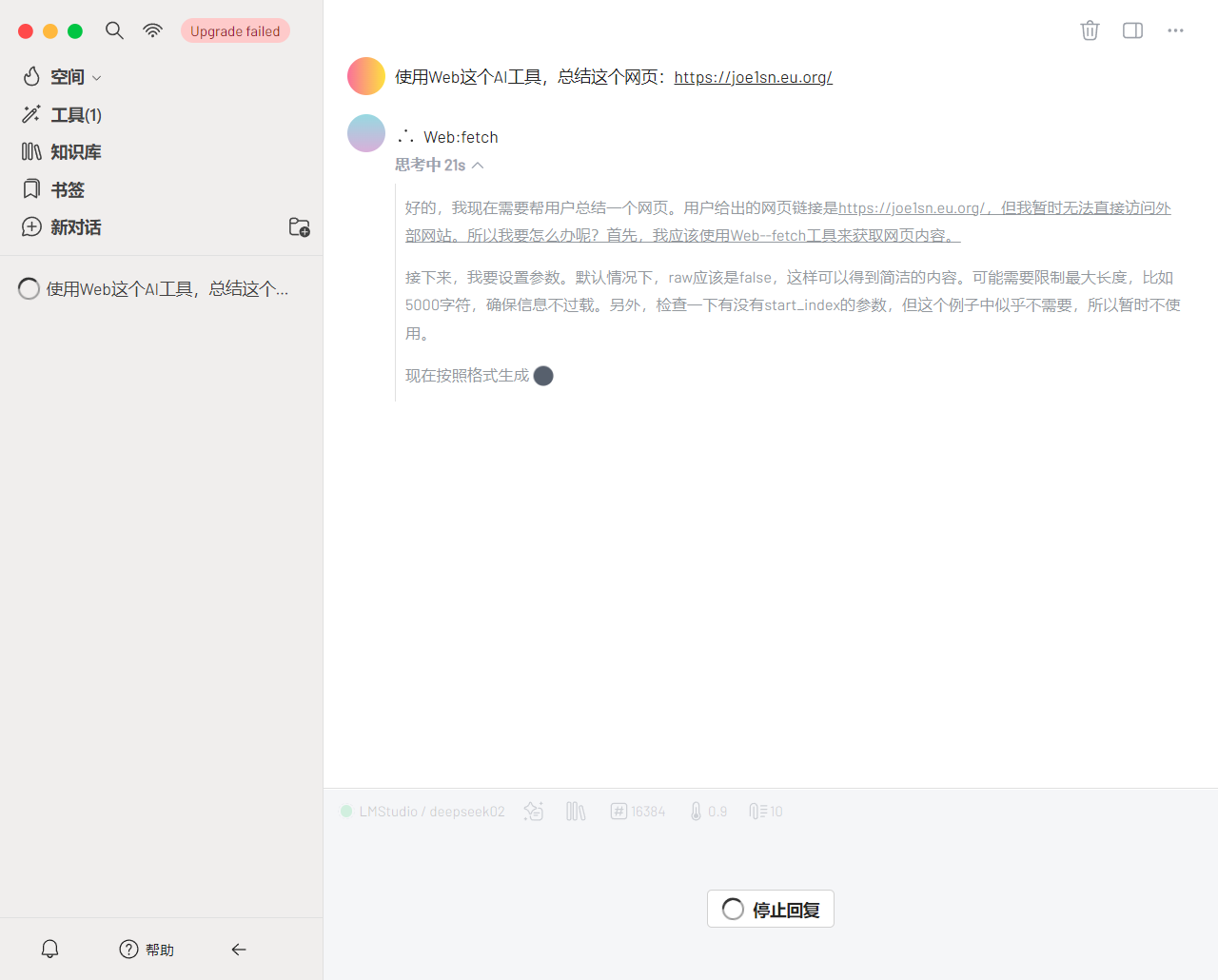

然后是本地的效果,反应的速度取决显卡,一般来说巨卡。因为本地模型是小参数,要笨很多,所以promote要详细些

安装MCP

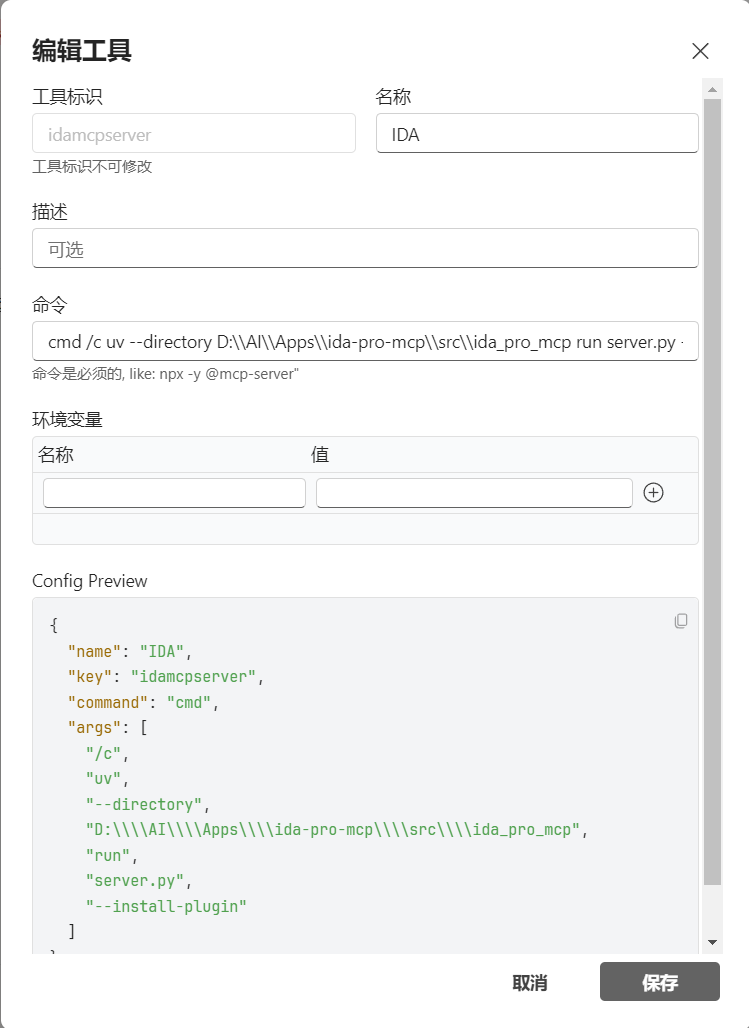

在工具中新建即可,这里用ida-pro-mcp这个举例

官方的json配置格式如下

1 | { |

在5ire中如下,他会自动完善其他参数

关于MCP管理

这里说了5ire,也可以使用其他的,个人认为比较初略的框架可以试试mcp-bridge,因为他只做了中间服务,连ui都没有,方便二次开发